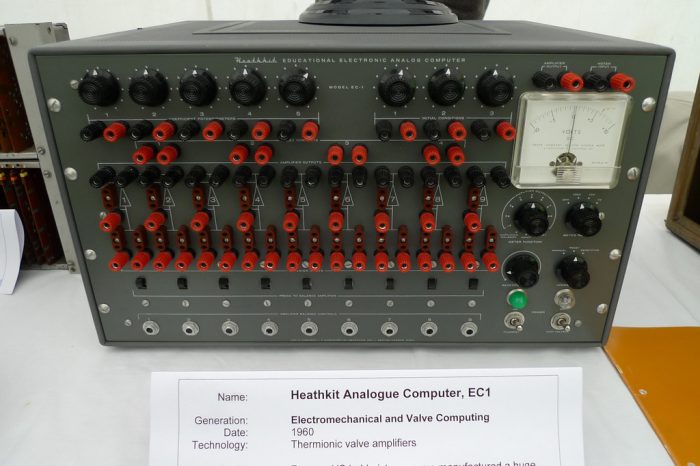

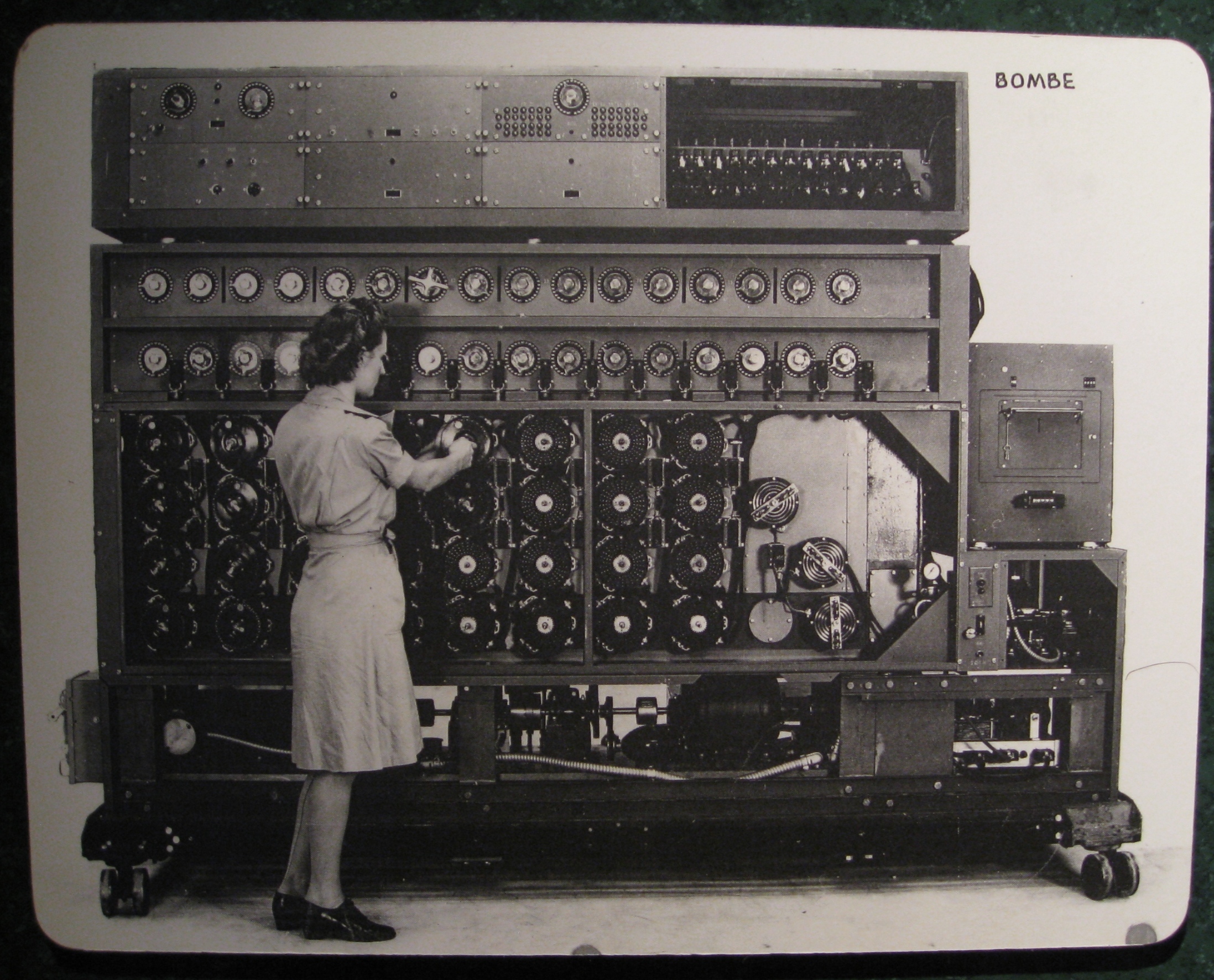

Die ersten elektromechanischen Rechengeräte (1900 bis 1955) verwendeten die Lochkartentechnologie, bei der jedes Datenzeichen in Form einer binären Kombination – gestanzte Löcher (Einsen) und deren Fehlen (Nullen) – auf einer Karte codiert wurde. Diese Maschinen konnten nur sortieren und tabellieren. Sperrige Geräte und begrenzte Möglichkeiten konnten den wachsenden Bedarf an Datenverarbeitung nicht decken.

Ende der 1950er-Jahre erschienen die ersten elektronischen Computer. Sie wurden im Maschinencode programmiert, da es damals keine höheren Programmiersprachen gab. Als externer Datenspeicher dienten Magnetbänder und -trommeln. Diese Computer konnten nur Rechenoperationen mit Zahlen und digital codierten Daten ausführen.

In den 1960er-Jahren erschienen die ersten Universal-Großrechner und die ersten höheren Programmiersprachen (Fortran, Algol-60, Cobol). Massive wechselbare Festplatten dienten als externer Direktzugriffsspeicher. Computer erhielten Multitasking-Betriebssysteme.

dienten als externer Direktzugriffsspeicher. Computer erhielten Multitasking-Betriebssysteme.

In den 1970er-Jahren „lernten“ Computer, Textinformationen direkt, ohne Zwischencodierung, zu verarbeiten.

Die 1980er-Jahre waren geprägt durch das Aufkommen der ersten PCs und Computernetzwerke. Entwickler-Frameworks und objektorientierte Programmiersprachen wurden eingeführt. Die ersten Versuche im Bereich KI wurden unternommen. Die Ausführung von Sprachbefehlen auf einem Computer wurde möglich. Es kam zu einer erheblichen Leistungssteigerung durch die Parallelverarbeitung in verteilten Großrechnersystemen.

In den 1990ern erschienen Multimedia-Datenbanken. Computer begannen, Multimedia-Daten zu verarbeiten.

Die 2000er-Jahre waren von einer rasanten Entwicklung des Internets geprägt.

Kommunikations- und IT-Technologien ermöglichten es, alle Informationen in den digitalen Raum zu verlagern und fördern den Übergang zur Informationsgesellschaft.